ЮНИСЕФтин эл аралык ECPAT уюму жана Интерпол менен биргеликте жүргүзгөн жаңы изилдөөсүнө ылайык, 11 өлкөдө 1,2 миллиондон ашык бала өткөн жылы алардын сүрөттөрү сексуалдык мүнөздөгү ачык жалган сүрөттөрдү түзүү үчүн колдонулганын билдиришти. Кээ бир аймактарда ар 25-бала жабыркаган, бул орто мектептеги бир окуучуга туура келет.

Балдар ИИнин жалган сексуалдык сүрөттөрдү түзүү үчүн колдонулушу менен байланышкан тобокелдиктерди түшүнүшөт. Изилдөө жүргүзүлгөн өлкөлөрдө, сурамжыланган балдардын эки үчүнчү бөлүгү ИИнин жалган сексуалдык материалдарды түзүү үчүн колдонулушу боюнча өздөрүнүн тынчсыздануусун билдиришти. Тынчсыздануу деңгээли өлкөдөн өлкөгө чоң айырмачылык көрсөтүп, маалымдуулукту жогорулатуу жана алдын алуу жана коргоо чараларын киргизүү зарылдыгын баса белгилейт.

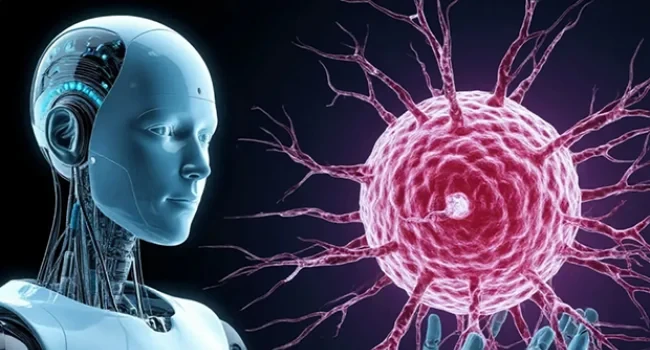

ИИ аркылуу түзүлгөн сексуализирленген балдардын сүрөттөрү балдарга карата сексуалдык зомбулукка байланышкан материалдардын (CSAM) категориясына кирет. Дипфейктердин зомбулук менен колдонулушу чын эле олуттуу көйгөй болуп, реалдуу зыян келтирет.

Балдардын сүрөттөрүн же инсандыктарын колдонуу аларды түздөн-түз курмандыктарга айлантат. Эгерде курмандыктарды аныктоо мүмкүнчүлүгү жок болсо да, ИИ аркылуу түзүлгөн материалдар балдарды сексуалдык эксплуатациялоону нормалдаштырууга, зомбулукка негизделген контентке талап жаратууга жана укук коргоо органдарынын жардамга муктаж балдарды аныктоо жана коргоо иштерин кыйындатууга жардам берет.

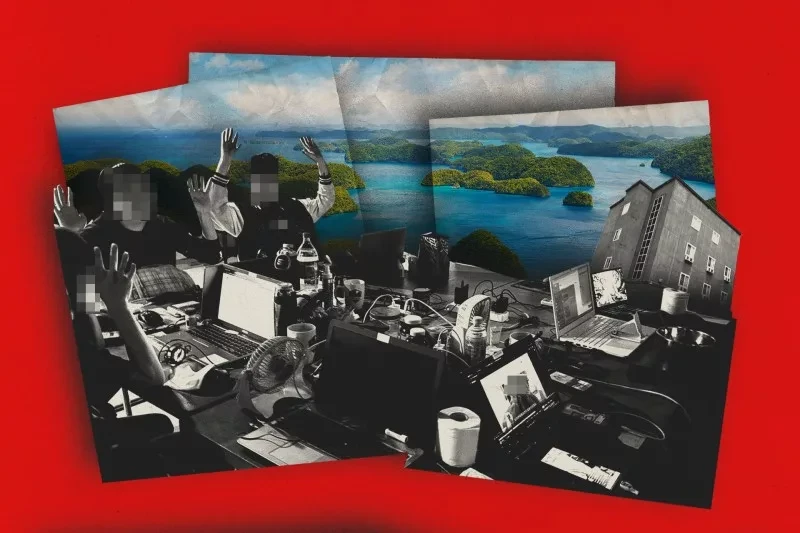

ЮНИСЕФ ИИнин иштеп чыгуучуларынын коопсуздук жана коргоо чараларын киргизүүгө умтулушун оң баалайт. Бирок, көптөгөн ИИ моделдери тиешелүү кепилдиктерсиз иштелип чыгууда. Генеративдүү ИИ инструменттери социалдык тармактарга интеграцияланганда, иштетилген сүрөттөрдүн тез жайылышына шарт түзөт.

Уюм ИИ колдонуп түзүлгөн балдарга карата сексуалдык зомбулук материалдарына байланыштуу өсүп жаткан коркунуч менен күрөшүү үчүн төмөнкү аракеттерди сунуштайт:

- Бардык өкмөттөр балдарга карата сексуалдык зомбулук материалдарын (CSAM) аныктамасын кеңейтүү керек, ИИ тарабынан түзүлгөн контентти камтып, анын түзүлүшүн, сактоосун жана жайылтуусун кылмыштуу деп эсептеши керек.

- ИИ иштеп чыгуучулары өз моделдерин мыйзамсыз колдонулушун алдын алуу үчүн иштеп чыгуу этаптарында коопсуз ыкмаларды жана ишенимдүү коргоо чараларын киргизиши керек.

- Цифрлык компаниялар ИИ аркылуу түзүлгөн сексуалдык мүнөздөгү материалдардын жайылышын алдын алуу үчүн механизмдерди иштеп чыгышы жана контенттин модерациясын жакшыртуусу керек, андыктан мындай материалдар курмандыктын кайрылуусунан кийин күндөрдүн ичинде эмес, дароо жок кылынсын.

Дипфейктердин зомбулук менен колдонулушунан келип чыккан зыян реалдуу жана тез арада чараларды талап кылат. Балдар мыйзамдар күчүнө киргенин күтпөйт.